Sumber: Reuters | Editor: Yudho Winarto

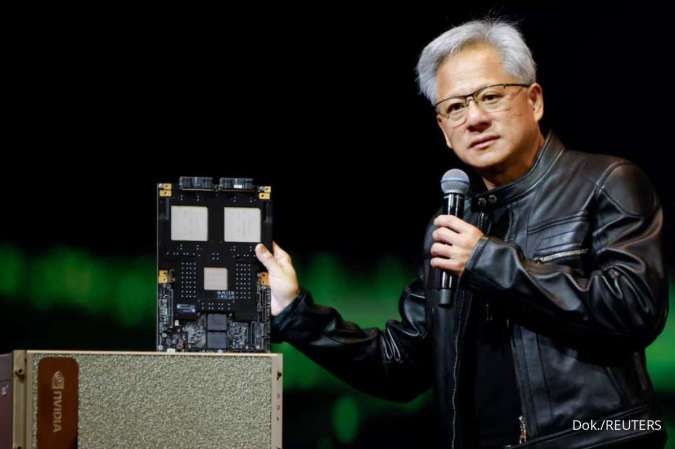

Fokus pada Chip Berbasis Memori

Pencarian alternatif GPU oleh OpenAI berfokus pada perusahaan yang mengembangkan chip dengan memori besar yang terintegrasi langsung di dalam silikon (SRAM).

Pendekatan ini dinilai memberi keunggulan kecepatan untuk chatbot dan sistem AI lain yang harus melayani jutaan permintaan pengguna.

Proses inference membutuhkan memori lebih besar dibanding pelatihan karena chip lebih banyak mengakses data ketimbang melakukan operasi matematika. GPU Nvidia dan AMD masih mengandalkan memori eksternal, yang dapat menambah latensi.

Baca Juga: Dolar Bertahan Menguat Selasa (3/2), Didukung Data Ekonomi dan Ekspektasi The Fed

Isu ini menjadi sangat terasa pada Codex, produk OpenAI untuk pembuatan kode komputer.

Sejumlah staf OpenAI mengaitkan sebagian kelemahan Codex dengan keterbatasan perangkat keras berbasis GPU Nvidia. Altman sendiri mengatakan pelanggan layanan coding OpenAI sangat memprioritaskan kecepatan.

Sebagai perbandingan, pesaing seperti Anthropic (Claude) dan Google (Gemini) diuntungkan oleh penggunaan chip buatan sendiri, seperti Tensor Processing Units (TPU) milik Google, yang dirancang khusus untuk inference dan penalaran AI.

Nvidia Bergerak Cepat

Seiring munculnya keraguan OpenAI, Nvidia dilaporkan mendekati sejumlah perusahaan pengembang chip berbasis SRAM, termasuk Cerebras dan Groq, untuk potensi akuisisi. Cerebras menolak dan memilih menjalin kerja sama komersial dengan OpenAI.

Baca Juga: Ekspor Minyak Venezuela Meroket 800.000 Bph, Kok Bisa?

Groq sempat berdiskusi dengan OpenAI dan menarik minat investor dengan valuasi sekitar US$14 miliar, sebelum akhirnya Nvidia melisensi teknologi Groq dalam kesepakatan tunai non-eksklusif pada Desember lalu.

Sejak itu, Groq lebih fokus menjual perangkat lunak berbasis cloud, sementara Nvidia merekrut sejumlah perancang chip dari perusahaan tersebut.

/2023/02/22/164240931.jpg)